Suchmaschinenoptimierung HowTo

Suchmaschinen-Optimierung (Search Engine Optimization, SEO) ist ein Fachbegriff für Maßnahmen, die dazu dienen, die Anzahl von Besuchern auf einer Website zu erhöhen. Durch die Ergebnisseiten, die nach der Eingabe von Suchausdrücken (=Keyphrases) in einer Suchmaschine erscheinen, kann der Benutzer auf eine Website gelangen.

Dieser Suchmaschinen-verkehr (=Traffic) weist in der Regel eine höhere Qualität auf, als der Traffic, der aus anderen Quellen stammt – inklusive des Traffics, der durch manuelle URL-Eingabe entsteht. Die angesprochene Qualität bezieht sich auf die Affinität des Benutzers zur Transaktions-Durchführung und auf die Verweildauer des Benutzers auf der Seite (Stickiness).

1 Crawlability

Damit eine Webseite indexiert werden kann, muss sie ein Minimum an Tauglichkeit besitzen, um von den Automaten der Suchmaschine, den sogenannten Crawlern durchsucht werden zu können. Die Seiten müssen so gestaltet sein, dass sie nicht nur dem „menschlichen“ Besuchern Inhalte zeigen, sondern auch dem Crawler. Als Kriterium für die Durchsuchbarkeit kann die Barrierefreiheit der Webseite herangezogen werden.

Diese Tauglichkeit wird „Crawlability“ oder auch „Crawler-Friendliness“ (=Crawler-Freundlichkeit) genannt. Sowohl der Inhalt der Website, als auch die Templates und die Seitenstruktur müssen für Crawler geeignet sein.

Crawlbare Webseiten werden von den Suchmaschinen durch ihre Crawler gefunden und regelmäßig nach (neuem) Inhalt durchsucht. Diese Funktionalität kann durch die Erstellung einer Sitemap Datei unterstützt und beschleunigt werden (www.sitemaps.org). Der Vorteil der Sitemaps Datei ist, dass eine Indizierung der Seiten in der Regel schneller erfolgt, als durch die Crawler alleine und dass eine Gewichtung der einzelnen Seiten innerhalb der Webseite möglich ist.

Crawler werden je nach Quelle auch „Spiders“ oder „Robots“ genannt. Den über Crawler gefundenen Inhalt speichern die Suchmaschinen in großen Datenbanken ab, um diesen im Hinblick auf die Relevanz des bereitgestellten Inhalts für eintreffende Suchanfragen zu bewerten.

2 Grundlagen der Suchmaschinen-Optimierung

Eine Maximierung des von Suchmaschinen generierten Traffics erfordert ein gewisses Maß an Flexibilität im Hinblick auf die Anpassung des Inhalts, sowohl auf der eigenen Seite („On-Page“), als auch als auch fremden Seiten („Off-Page“). Nur so kann letztlich die Position im Ranking der Suchmaschinen (Search Engine Ranking Position, SERP) für die relevanten Suchausdrücke verbessert werden.

Suchmaschinen-Optimierung (SEO) und der damit verbundene Traffic basiert auf folgenden Voraussetzungen:

- Suchmaschinen Traffic ist Keyphrase-bezogen

- jeder Suchbegriff liefert unterschiedliche Ergebnisse

- jede Suchtechnologie liefert unterschiedliche Ergebnisse

- Konzentration auf Google (Google ist augenblicklich der Vorreiter der Branche, dem alle anderen Hersteller folgen. Marktanteil in Deutschland ca. 89% )

- Traffic Quantität pro Keyphrase ist abhängig von

- Popularität der jeweiligen Suchausdrücke (in entspr. Sprachraum und Geografie)

- Relevanz des Inhalts der Webseite zu dem gesuchten Thema

- Link Popularität der Webseite

- Übereinstimmung von Suchausdruck und Webseiteninhalt (Content-Match)

- Positionierung der Ergebnisse im Ranking der Suchmaschine (SERP)

- Klick-Attraktivität der angezeigten Suchergebnisse (Motivation für den Benutzer)

- Suchmaschinen-Optimierung (SEO) erhöht die Traffic Quantität durch

- die Auswahl von bekannten und passenden Suchausdrücken

- die Verbesserung der Ranking Position auf den Ergebnisseiten der Suchmaschinen (SERP)

- die Erhöhung der Klick-Attraktivität der Suchergebnisse

Die Entwickler von Templates und Redakteure für Inhalte sollten die Website-Struktur und den Website-Inhalt suchmaschinengerecht anpassen. Die gängigste Variante für SEO stellt die Bearbeitung von (On-)Page Elementen dar. Entwickler und Redakteure sollten bei allen Aktivitäten die Grundsätze der Suchmaschinenoptimierung im Auge haben, auch wenn SEO nicht alleiniges Ziel des Redaktionsprozesses ist.

SEO unterscheidet zwischen:

- On-Page Maßnahmen

- Maßnahmen, die sich auf Elemente des Templates und des Inhalts von einer Webseite oder dem betrachteten Internetauftritt (Website) beziehen. Diese Elemente können direkt durch einen Editor, Template Designer oder einen Techniker beeinflusst oder kontrolliert werden.

- Off-Page Maßnahmen

- Maßnahmen, die sich auf Elemente beziehen, die sich nicht direkt auf der optimierten Webseite befinden, sondern anderswo:

- entweder auf einer anderen Unterseite des “eigenen“ Internetauftritts (On-Site)

- oder auf einer speziellen Unterseite eines anderen Internetauftritts (Off-Site)

- Diese Elemente sind zumeist direkt beeinflussbar, wenn Links On-Site plaziert werden. Sogar wenn Links Off-Site plaziert werden, besteht in einigen Fällen die Möglichkeit der indirekten Beeinflussung, indem Kooperationen mit Managern, Redakteuren, Template Designern oder Technikern der Website des Dritten eingegangen werden (z.B. im Sinne von Online-Kooperationen und Sponsoring).

3 Durchführung der Suchmaschinen-Optimierung

SEO wird anhand nachfolgend beschriebener Schritte durchgeführt:

3.1 Auswahl bekannter und passender Suchausdrücke

Jeglicher Traffic, der über Suchmaschinen generiert wird, baut auf Suchbegriffen (=Keyphrases) auf, die Benutzer für ihre Suche verwenden. Die Qualität der Übereinstimmung zwischen einem verwendeten Suchbegriff und dem Inhalt innerhalb bestimmter Elemente der Website, der für Suchmaschinen relevant ist, ist der bedeutendste Einflussfaktor auf die Rankingposition in den Suchergebnisseiten.

Die SERPs (= Search Engine Result Page oder Search Engine Ranking Position) sind die Ergebnispositonen der Suchmaschine – je höher eine Website gelistet ist, desto besser – die Position der Website hat einen erheblichen Einfluss auf die Quantität der Klicks, die durch die Aufrufe der SERPs erzeugt wurden.

Zudem ist die Quantität des Traffics eines bestimmten Suchbegriffs direkt mit der Traffic-Quantität, die durch eine spezielle SERP generiert wurde, verbunden.

Um den durch Suchmaschinen generierten Traffic zu maximieren, sollte ein Content-Manager daher Suchbegriffe verwenden, die:

- relevant für den Inhalt der betreffenden Website sind und

- die im allgemeinen Sprachschatz vernehmlich verwendet werden

Beispiel:

der Begriff „Tempo“ ist (in Deutschland) populärer als der Begriff „Einwegpapiertaschentuch“

im englischen ist zum Beispiel „color“ weiter verbreitet als „colour“

Die auf diesem Wege identifizierten Keyphrases sollten im Anschluss gefiltert werden. Dabei sollten Begriffe ausgefiltert werden, die zu allgemein sind und schon zu stark vom Wettbewerb besetzt sind, der bereits SEO betreibt.

Auf keinen Fall sollte ein Content-Manager versuchen, seinen Inhalt im Hinblick auf Keyphrases zu optimieren, die einen starken Traffic versprechen, für die er aber keinen relevanten Inhalt auf seinen Seiten zur Verfügung stellt. Früher oder später werden sowohl Benutzer als auch Suchmaschinen – automatisch oder durch manuelle Prozesse der Betreiber – dies erkennen. Das kann ein Unternehmen durch die Gefahr des Ausschlusses seines Domain-Namens vom Index teuer zu stehen kommen.

Sind Keyphrases erst einmal identifiziert, so sollten Sie unter nachfolgenden Aspekten optimiert werden.

- Das Zusammensetzen von Worten mit “-“ oder ohne “ “ Bindestrich macht einen großen Unterschied im Hinblick auf die SERP. Wobei in URLs der Bindestrich “-“ dem Unterstrich “_“ vorzuziehen ist.

- Nutzer suchen im Nominativ (und nicht in irgendwelchen anderen grammatikalischen Formen), um die Anzahl der Treffer zu maximieren.

- Die Optimierung für Worte in der Singular- oder Plural-Form sollte sorgfältig überdacht und mit einer speziellen Analyse gestützt werden.

Als Werkzeug für solche Betrachtungen eignen sich Tools wie:

Google Trends (http://www.google.de/trends?q=colour,+color) oder

Google Insights (http://www.google.com/insights/search/#q=colour%2C%20color)

3.2 Verbesserung der Ranking-Position (SERP)

Die von Google erfundene PageRank™-Technologie bestimmt sowohl die Link-Popularität einer Webseite, als auch den Grad an Übereinstimmung zwischen dem vom Benutzer eingegebenen Suchbegriff und dem Inhalt der Webseite. Die Ergebnisse beider Faktoren werden herangezogen und nach festgelegten Algorithmen vereinigt, um so die SERP für eine spezielle Webseite und einen speziellen Suchbegriff (Keyphrase) zu bestimmen.

Alle populären Suchmaschinen haben diese Technologie inzwischen in ihren Algorithmen adaptiert. Daher ist eine Optimierung für Google auch gleichzeitig eine Optimierung für alle andern großen Suchdienstanbieter.

Folglich helfen bei der Suchmaschinen-Optimierung zwei Aktivitäten, um die Position im Ranking der Suchmaschinen (SERPs) zu verbessern.

3.3 Verbesserung der Link-Popularität

Die Link-Popularität einer Webseite wird durch die Links bestimmt, die von anderen Seiten auf diese Seite verweisen. Aus der Sicht der zu optimierenden Webseite handelt es sich hierbei um Traffic zuführende Links, sogenannte Inbound-Links. Links, die aus der Webseite herausführen werden als Outbound-Links bezeichnet.

Googles PageRank™ Algorithmus zählt dabei nicht nur stumpf die Anzahl an Inbound-Links, sondern bewertet auch jeden einzelnen Inbound-Link anhand der Popularität der Webseiten, auf denen diese Inbound-Links platziert sind. Das Verhältnis von eingehenden zu ausgehenden Links fließt ebenfalls in die Berechnung PageRank™ ein.

Off-Page-Optimierungen können, in seltenen Fällen von Redakteuren selbst durchgeführt werden, da die betroffenen Links entweder auf der Website eines Dritten befinden oder auf Seiten der „eigenen“ Website die in der Verantwortung von anderen Redakteuren liegt.

Redakteure sollten für die Inhalte, die sie schreiben, Redakteure anderer Seiten veranlassen auf die Inhalte Inbound-Links mit einem relevanten Anchor-Text zu setzen.

Relevante Off-Page Elemente sind:

- Inbound-Links:

- Anzahl an Inbound-Links (<a>-Tags)

- Anchor Text von Inbound Links (<a href=…> Anchor-Text </a>)

Es ist dabei nicht nur wichtig, dass ein Inbound-Link existiert, sondern auch mit welchem Text er “beschrieben” wird. Eine Suchmaschine betrachtet den Anchor-Text von Links (Link-Text) (<a href=…> Anchor-Text</a>) als eine relevante Beschreibung für das Ziel des Links. Keyphrases, die innerhalb dieses Anchor-Textes benutzt werden, werden direkt mit der Webseite (URL) in Verbindung gebracht, auf die der Link verweist.

Beispiel:

Ein Link mit dem Anchor-Text “Bitte klicken Sie hier” ist aus Sicht der Suchmaschinen-Optimierung nutzlos, wohingegen ein Anchor-Text “SEO HowTo auf Hagenfragen.de“ die Positionierung der Seite im Ranking der Suchmaschinen verbessern könnte, wenn nach der Keyphrase “SEO HowTo” gesucht wird.

Wenn die Anzahl von Inbound-Links hoch und/oder der PageRank™ der Website mit deren Platzierung hoch genug ist, können Off-Page-Kriterien so einflussreich sein, dass eine Webseite eine Top-SERP für einen Suchbegriff erreichen kann, der überhaupt nicht im Inhalt der Webseite selbst auftaucht.

Beispiel:

Bis vor kurzem (gut is schon länger her – aber ist ein tolles Beispiel) lieferte die Keyphrase “miserable failure” (dt. etwa erbärmlicher Versager) unter der Top-SERP den Lebenslauf von US Präsident George W. Bush – und das obwohl “miserable failure” sicherlich nicht in dessen Lebenslauf auftaucht…

Der Grund hierfür liegt darin, dass viele Leute die George W. Bush nicht mögen, einen Inbound-Link für den Lebenslauf auf ihrer Webseite platziert haben, der den Anchor-Text “miserable failure” enthält.

Dieses als Google-bombing bekannt gewordene Phänomen wurde aufgrund der negativen publiciy Anfang 2007 von Google ausgemerzt. Daher funktioniert dieses plakative Bush-Paradebeispiel heute nicht mehr.

Andere Anchor-Text-Phänomene funktionieren aber weiterhin. Bei einer Suchen nach „hier“ erhält man als Top-SERP die Downloadseite des Adobe Readers, weil fast jede Seite die PDFs bereitstellt einen Link mit dem Wort „hier“ enthält.

Inbound-Links für spezielle Inhalt-Seiten können auch auf anderen Webseiten desselben Internetauftritts eingefügt werden. Deshalb müssen Redakteure sicherstellen, dass jede Webseite, die sie erstellen, einen Inbound-Link von einer anderen Webseite hat (On-site oder Off-site), die genügend Popularität für die Crawler aufweist. Ein guter Indikator für eine ausreichende Popularität ist, wenn der Google PageRank™ der Webseite höher als 2 ist. Der Google PageRank™ lässt sich mit der Google Toolbar im Internet Explorer ermitteln.

3.4 Verbesserung der Übereinstimmung zwischen Suchbegriffen und Webseiteninhalt

On-Page-Optimierungen ermöglichen dem Redakteur, die Qualität der Übereinstimmungen zwischen Suchbegriffen und Webseiteninhalt und die Quantität der Keyphrases, die Inhalt-Übereinstimmungen produzieren, zu beeinflussen. Zudem beschäftigen sich On-Page-Optimierungen mit der Erhöhung der Click-Through-Rate für Suchtreffer, die auf den Ergebnisseiten der Suchmaschinen ausgegeben werden.

Relevante On-Page Elemente sind (sortiert nach Relevanz – hoch bis gering):

- Seiten-Titel (<title>)

- URL der Website (-Domain, -Pfad, -Dateiname)

- Body-Text

- Überschriften (<h1>, <h2>, <h3>)

- Fetter Text (<b>)

- Kursiver Text (<i>)

- Text in Listen (<ol>, <ul>)

- Erstes Drittel des Body-Text (inkl. Alt-Attribute der Bilder (<img src=…alt=“[Alternativer Text]“>))

- Restlicher Body-Text

- Seiten-Beschreibung (<META NAME=“description“ …>)

Anmerkung: META-Tag „Keywords“ (Schlüsselwörter) wird aufgrund des früher betriebenen Missbrauchs von heutigen Suchmaschinen komplett ignoriert. Ähnlich verhält es sich mit dem META-Tag „Description“. Suchmaschinen lesen diesen zwar aus, und verwenden Ihn als Kurztext in den Suchergebnissen, wenn auf der eigentlichen Seite kein passender Text gefunden wird, messen dem Tag aber ein sehr geringes Gewicht bei.

Der Algorithmus von Suchmaschinen, der den Grad an Übereinstimmung zwischen den gesuchten Begriffen und dem Inhalt der Webseite bestimmt, ist ein wichtiges Element, für die spätere Positionierung SERP.

Der Algorithmus prüft nicht nur ob das Keyword bzw. die Keyphrase, auf der Webseite vorkommen, sondern bestimmt auch die Qualität der Übereinstimmung anhand bestimmter Kriterien. Diese Kriterien sind:

- Keyword Prominence (Keyword Prominenz):

- Positionierung der Keywords auf der Webseite im Hinblick auf deren beigemessene Bedeutung

- Keyword Proximity (Keyword Nähe):

- Nähe der Keywords innerhalb einer Keyphrase voneinander und Reihenfolge

- Keyword Density (Keyword Dichte):

- Verhältnis der Anzahl der Keywords im Vergleich zur Menge des restlichen Textes

- Keyword Frequency (Keyword Häufigkeit):

- Absolute Häufigkeit von Keywords im Inhalt der Webseite

Für jedes dieser Kriterien existieren auf Basis von aktivem Erfahrungsaustausch zu dem Thema SEO Thesen, Regeln und Richtlinien, wie man, durch die auf Suchmaschinen ausgerichtete Erstellung von Inhalt und Webseite-Templates, den Erfolg von SEO maximieren kann.

Dennoch können keine allgemeingültigen, absoluten Parameter festgelegt und dokumentiert werden, da Suchmaschinen-Algorithmen sehr komplex sind, sich ständig ändern und sich von Suchmaschine zu Suchmaschine unterscheiden. Um optimale Ergebnisse zu liefern, müssen kontinuierlich Veränderungen beobachtet, interpretiert und berücksichtigt werden.

Daher besteht die Notwendigkeit, verlässliche und aktuelle Informationsquellen aufzutun, Informationen nach eigenen Erfahrungen und eigenem Ermessen zu konsolidieren und im Anschluss daran, die konsolidierte Information auf experimenteller Basis iterativ anzupassen.

Die Optimierung des Inhalts von Webseiten, zur Erreichung bestmöglicher Position im Ranking von Suchmaschinen (SERPs), basiert auf bestimmten Schritten innerhalb der zuvor genannten Dimensionen.

3.5 Keyword Prominence (Keyword-Prominenz):

Positionierung der Keywords bzw. der Keyphrase auf der Webseite im Hinblick auf deren beigemessene Bedeutung

- Viele Suchmaschinen gewichten die Worte stärker, die in bestimmte HTML-Tags auftauchen, die normalerweise dazu verwendet werden, Worte und Ausdrücke im Inhalt-Layout hervor zu heben. Nachfolgend sind diese Tags in der Reihenfolge ihrer Bedeutung genannt: Überschrift Title, URL, Überschriften (<h1>, <h2>, <h3>), Fett (<b>), Kursiv (<i>), Listen (<ol>, <ul>), Body-Text im ersten Drittel der Seite, Restlicher Body-Text, Description (<META NAME=“Description“ …>).

- Die meisten dieser Tags produzieren automatisch eine spezielle Formatierung des betroffenen Textes. Diese Formatierungen sind normalerweise nicht erwünscht, da diese zumeist nicht den Webstyleguides und den Layout-Prinzipien entsprechen. Das Revidieren dieser sichtbaren Änderungen, beispielsweise hervorgerufen durch die Fett- und Kursiv-Tags, ist relativ unkompliziert. CSS kann dazu verwendet werden, die Schriftgröße, Schriftart, etc. anzupassen. Jedoch sollte hier mit Vorsicht vorgegangen werden (mit externen CSS-Stylesheets und Robot-Exclusion für CSS Dateien).

- Im Allgemeinen sollte bei der Erstellung von Überschriften darauf geachtet werden, dass nur die allerwichtigsten Keywords und nichts anderes zu verwenden. Das ist nicht immer leicht, da eine Überschrift für diejenigen, die die Seite lesen, auch Sinn machen muss. Daher ist das Befüllen von Tags mit Keywords nach dem Zufallsprinzip sicherlich keine Lösung.

- Suchmaschinen messen den Wörtern, die am Seitenanfang auftauchen, eine stärkere Gewichtung zu, als solchen, die eher/häufiger in der Mitte oder im unteren Teil aufgefunden werden, ist es wichtig, im oberen Teil der Seite bedeutende Keywords einzupflegen. Nichtsdestotrotz muss ein Text einen natürlichen Fluss aufweisen. Niemand möchte einen Text lesen, der lediglich eine Aneinanderreihung von Keywords darstellt. Die Absprungrate der Nutzer soll so gering wie möglich gehalten werden.

- Fragwürdige Maßnahmen, wie beispielsweise das Verstecken von Text durch extremen Gebrauch von „display:none“, Textfelder (Layer) mit unmöglichen Positionen, weiße Schrift auf weißem Hintergrund etc. müssen unter allen Umständen vermieden werden. Diese als Cloaking bezeichneten Techniken können dazu führen, dass die Seite vom Suchindex ausgeschlossen wird. Bei einem normalen Umgang mit versteckten Feldern (z.B. Flyout-Menüs) ist kein Ausschluss oder Penalty zu befürchten.

- Anmerkung: Dieses verstecken von Inhalten hat 2006 dazu geführt, das Google alle BMW Webseiten aus dem Index genommen hat.

3.6 Keyword Proximity (Keyword-Nähe):

Nähe der Keywords innerhalb einer Keyphrase voneinander und Reihenfolge

- Suchmaschinen wie z.B. Google benutzen das Prinzip der „Keyword-Nähe“ als Teil ihrer Ranking Formel. Wie der Name „Keyword-Nähe“ widerspiegelt, geht es darum, wie nah beieinander die entsprechenden Keywords stehen. Die zu optimierenden Keywords einer Seite sollten folglich so nah wie möglich beieinander stehen – idealerweise in der entsprechenden Reihenfolge.

- Substantive zwischen den Keywords sollten auf jeden Fall vermieden werden. Auch Füllwörter (Stoppwörter) wie „in“, „ein“, „eine“, „der“, „die“, „das“ sollten nach Möglichkeit vermieden werden. Suchmaschinen ignorieren zwar Füllwörter in der Regel bei der Bewertung. Wenn aber zwei Treffer gefunden werden, einer mit und einer ohne Füllwörter, dann wird der ohne Füllwörter aufgrund er höheren Keyword-Nähe bevorzugt.

3.7 Keyword Density (Keyword-Dichte):

Verhältnis der Anzahl der Keywords im Vergleich zur Quantität des restlichen Textes

- Dieses Prinzip ist auch bekannt als „Keyword-Gewichtung“ oder Messung des Verhältnisses von Keywords im Verhältnis zur Gesamtzahl der im Text enthaltener Wörter. Experten sind der Meinung, dass eine Keyword-Dichte von 4,5% bis 13,0% einen guten Wert darstellt.

- Anmerkung: Stoppwörter und sehr häufige Worte (wie „ein“, „in“, etc.) werden von den Suchmaschinen in der Regel ignoriert.

- Um ein Gespühr für die richtige Dichte zu bekommen empfiehlt es sich im Vorfeld die Top-Ten Seiten für die entsprechenden Begriffe bzgl. der Dichte zu analysieren.

3.8 Keyword Frequency (Keyword-Häufigkeit):

Absolute Häufigkeit von Keywords bzw. der Keyphrase im Inhalt der Webseite

- Die Keyword-Häufigkeit misst, wie oft ein Keyword innerhalb des Textes einer Seite auftaucht. Dieses Prinzip hängt stark mit dem Prinzip der Keyword-Dichte zusammen. Suchmaschinen fordern mehr als eine Wiederholung des Keywords innerhalb eines Textes, um sicherzustellen, dass es sich beim Vorkommen der Keyphrase nicht um einen Ausnahmefall handelt. Die Anzahl empfohlener Wiederholungen bewegt sich zwischen 3-7-mal je nach Länge des Textes. Jedoch können auch andere Größenordnungen den gewünschten Erfolg bringen, konkret hängt das von dem jeweiligen „Wettbewerb“ um die entsprechenden Keyphrase im jeweiligen Sprachraum ab.

Die oben genannten Kriterien werden von den Algorithmen der Suchmaschinen auf den Inhalt im Rahmen jedes der erwähnten On-Page-Elemente angewandt.

Unabhängig von der Bedeutung individueller On-Page-Elemente, sollte im Zuge einer Suchmaschinen-Optimierung keine Fokussierung auf spezielle Elemente vorgenommen werden.

Beispiel:

Ein optimierter Titel und gute Überschriften versprechen ohne einen Keyword-bereicherten Body-Text nur wenig Erfolg. Idealerweise sollte ein Keyword immer mehrmals auf einer Webseite auftauchen.

3.9 Erhöhung der Klick-Attraktivität der Suchergebnisse

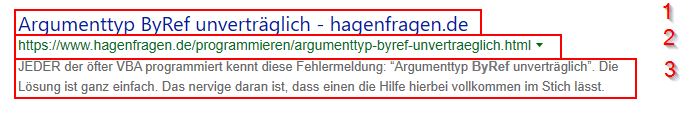

Der über Suchmaschinen generierte Traffic weißt neben dem rein technischen Aspekt wie Ranking Position noch eine menschliche Komponente auf, die sogenannte Klick-Attraktivität. Die Klick-Attraktivität eines Suchtreffers hängt maßgeblich von der Qualität des von Google angezeigten Text Snipplets und der vom Benutzer erwarteten Relevanz des Suchtreffers ab. Die wahrgenommene Relevanz hängt von einer schnellen Bewertung, der im Suchergebnis sichtbaren Schlüsselelemente ab, passt der Text nicht zu der Erwartung wird nicht geklickt.

Ein angezeigter Suchtreffer besteht zumeist aus folgenden Elementen:

- Seiten-Titel (<title>)

- Seiten Beschreibung (Snipplet, Clipping Text) (<META NAME=“Description“ …>) oder

Keyphrase-relevanter Auszug aus dem Body-Text der Seite - URL der Webseite (Domain, Pfad, Dateiname)

Während der META-Tag „Keyword“ für die SERP Optimierung unbrauchbar ist (aktuelle Suchmaschinen berücksichtigen diesen Tag seit Jahren nicht mehr), können mit dem META-Tag „description“ noch positive Ergebnisse erzielt werden. In manchen Suchmaschinen ermöglicht dieser META-Tag noch die Beschreibung von Webseiten zu kontrollieren. Vor allem dann, wenn keine Übereinstimmung von Suchbegriff und Inhalt gefunden wird, dafür aber innerhalb des Titel und den Anchor-Texten der Inbound-Links, wird der META-Tag „description“ dazu verwendet, den in der Ergebnisseiten der Suchmaschinen sichtbaren Text (Clipping-Text), zu erzeugen. Verwenden Sie diesen Tag und verfassen Sie eine Beschreibung, die so aufgebaut ist, dass sie möglichst viele Leute animiert auf den Link zu klicken um die entsprechende Website zu besuchen.

Neben dem Clipping-Text sind auch Seitentitel und URL sichtbare Elemente einer SERP. Was ein Benutzer dort sieht, lässt ihn entscheiden, ob er auf diesen Link klickt oder ob er zur nächsten SERP übergeht. Daher sollte alle Informationen entfernt werden, die die Relevanz des sichtbaren Textes nicht erhöhen.

Beispiel:

Ein Seitentitel wie “Artikel – hagenfragen.de” ist nicht 100%ig dazu geeignet, die Relevanz für den Benutzer hervorzuheben. Aus Sicht einer Suchmaschinen-Optimierung wäre folgender Seitentitel besser geeignet: “Regulärere Ausdrücke, die einem das Leben erleichtern – hagenfragen.de”.

3.10 Beobachtung der Suchergebnisse

Algorithmen der Suchmaschinen und Strategien der Suchmaschinen, um Webseiten zu crawlen, Inhalt zu scannen und die Relevanz im Hinblick auf die Keyphrases zu bewerten, werden ständig optimiert. Daher ist es für einen Content Manager sehr wichtig, diese Änderungen im Markt zu beobachten und im Hinblick auf die Auswirkungen, auf den durch Suchmaschinen generierten Traffic, zu bewerten.

Diese Beobachtungen sollten auf einer regelmäßigen Basis stattfinden und sich auf folgende Punkte konzentrieren: SERPs, Benutzer-Verhalten im Hinblick auf aus SEO-Maßnahmen resultierende SERPs und das Verhalten von Benutzern, die durch die Suche über Keyphrases auf Seiten gelangen (im Vergleich zu den restlichen Benutzern).

Um diese Beobachtung durchzuführen, benötigen Content Manager Werkzeuge, die die relevante Information erfassen, eine Interpretation ermöglichen und das Ziehen von Schlussfolgerungen zulassen.

Idealerweise besteht die Möglichkeit sowohl den Markt für Suchmaschinen in dem relevanten Land/Länder als auch die Erfahrungen und Trends im Bereich Suchmaschinen-Optimierung (SEO) zu beobachten, um Änderungen frühzeitig zu erkennen und zu antizipieren. Ziel ist eine Vermeidung eines ungeplanten Rückgangs von Suchmaschinen-Traffic, also das Sichern der „Nachhaltigkeit“ von Maßnahmen der Suchmaschinen-Optimierung.

4 Operativer Prozess der Suchmaschinen-Optimierung

4.1 URL Struktur und Domainkonzept

Vor der Umstellung einer Website auf zum Beispiel auf ein neues Content Management System (CMS) müssen aus SEO Gesichtspunkten vor der Umschaltung des alten CMS Systems muss darauf geachtet werden, dass alle alten URLs noch funktionieren. Diese URL Migration hat mehrere Hintergründe. Eine menschliche Komponente, wenn Nutzer Bookmarks auf Seiten gesetzt haben, und eine technische Komponente bezüglich der Inbound-Links. Diese Inbound Links können Links von Fan-Seiten, Blogs, Fahrzeugtestseiten, Links von privaten Seiten und vor allem Deeplinks von Suchmaschinen sein. Wenn sich bei der CMS Umstellung alle URLs der Seite ändern, landen alle Nutzer –menschliche und mechanische- auf der 404-Page-not-found-Fehlerseite des neuen CMS.

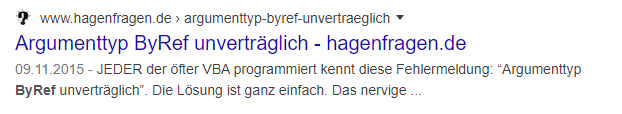

Ein zusätzlicher Aspekt bei Suchmaschinen ist hierbei, dass jede Seite eine sogenannte Page-History hat. Diese Page-History beinhaltet alle Änderungen der Seite, ein aktuelles Abbild der Seite (Google-Cache) sowie Daten über Alter und Größe der Seite und den wichtigen PageRank. Diese Daten fließen massiv in die Bewertung der Seite und damit in die Suchergebnisse ein. So besteht zum Beispiel die Seite mit der URL: https://www.hagenfragen.de/programmieren/argumenttyp-byref-unvertraeglich.html bereits seit dem Jahr 2015.

Wenn nun eine neu registrierte Seite einen Artikel über „Argumenttyp byref“ schreibt ist diese nicht so relevant wie die 6 Jahre alte Seite. Wenn sich aber die URL der Seite durch eine CMS Umstellung in https://www.hagenfragen.de/VisualBasic/argumenttyp-byref-unvertraeglich.html ändert wird die History gelöscht, und es ist für die Suchmaschinen eine neue Seite. Daher müssen alle alten Seiten auf neue Umgeleitet werden. Diese Umleitung muss mit einem http-Status 301 durchgeführt werden.

Daraus ergeben sich folgende Maßnahmen:

URL-Struktur muss nach CMS Auswahl final festgelegt werden

- Die (URL-) Struktur der neuen www.hagenfragen.de Webseite muss vor der CMS Implementierung bis in das letzte Detail geplant werden, damit die Pfade und URLs später nicht mehr geändert werden müssen.

SEO Domain-Konzept für die neue hagenfragen.de muss erstellt und umgesetzt werden.

- Es muss vor der Umschaltung auf die neue www.hagenfragen.de muss ein Domain Konzept erstellt werden um die Page History und den PageRank einzelner wichtiger Seiten zu erhalten. Die alten URLs müssen auf die neuen gemappt werden.

- (Mapping alte Sitemap auf neue Sitemap -> Vanity Domain Redirects)

Allgemeine URL Regeln

- Die URL einer Seite sollte die Keywords der jeweiligen Seite enthalten (sprachabhänig). Die URL muss immer in Kleinbuchstaben, ohne „/“ (Trailing Slash“), ohne „?“, ohne „_“, ohne SessionIDs und Sonderzeichen ausgeliefert werden. Die URL muss mit „/“ oder „-„ getrennt werden. Die gesamte URL sollte nicht länger als 100 Zeichen sein (Snippet-Länge in Google)

Das System muss gelöschte und ersetzte Seiten auf neu erstellte Seiten umgeleiten

- Es darf im System keine verwaisten Seiten geben. Ersetzte Seiten müssen mit http-Status 301 auf vorhandene oder neu erstellte Seiten umgeleitet werden

Jede Domain muss eine Standard-Domain haben

- Beispiel: hagenfragen.de und www.hagenfragen.de

4.2 Crawlability

- Das System muss die komplette Seitenstruktur für Suchmaschinen-Robots crawlbar ausliefern

- Das System muss textuelle Inhalte in Flash Containern auch HTML-formatiert zur Verfügung stellen. Das System muss ohne HTML Frames und iFrames auskommen

- Das System muss ohne JavaScript navigierbar sein, oder jeder Link in JavaScript muss auf der jeweiligen Seite als normaler HTML Link verfügbar sein. Fachbegriff: Graded Browsing

Robots.txt und Sitemaps.xml

- Das CMS muss domainspezifische robots.txt und sitemaps.xml erzeugen können.

- Die Sitemap muss automatisch generierte werden wenn Seiten erstellt, verschoben oder gelöscht wurden.

- „Unter jeder Länderdomain soll eine robots.txt verfügbar sein, welche einen relati-ven Verweis auf die länderzugehörige Sitemap (sitemaps.xml) enthält.

- Die Dateien müssen den Spezifikationen von http://www.sitemaps.org/protocol.php und http://www.robotstxt.org entsprechen.

- Für besser gewichtete Suchergebnisse in Suchmaschinen soll für die gelisteten Sei-ten in den Sitemaps eine logarithmisch abfallende Gewichtung der Seiten erfol-gen.

- Das CMS soll die Sitemap im gz (GnuZip) Format auf dem Server abgelegen“

- Das CMS muss auf der länderübergreifenden Domain (derzeit smart.com) die Si-temaps aller Länder in der robots.txt referenzieren.

- Das CMS muss auf sprachübergreifenden Domains (smart.ch) die Sitemaps aller Sprachen in der robots.txt referenzieren.

- Das System sollte die Möglichkeit bieten bestimmte Seiten oder Zweige mittels ro-bots.txt in Suchmaschinen auszublenden. Bestimmte nicht für SEO relevante Seiten sollten im CMS so markiert werden können, dass sie aus dem Index der Suchma-schinen ausgeblendet werden können

Fehlerseiten

- Das System muss W3C konforme W3C HTTP Errorcode Fehlerseiten ausliefern. Die Seiten müssen dem Look & Feel der smart-Seiten entsprechen

Verwaiste Seiten

- Das System muss gelöschte und ersetzte Seiten auf neu erstellte Seiten umgeleiten

- Es darf im System keine verwaisten Seiten geben. Ersetzte Seiten müssen mit http-Status 301 auf vorhandene oder neu erstellte Seiten umgeleitet werden. Das CMS sollte dies dem Redakteur beim löschen von Seiten automatisch vorschlagen

Das System muss WC3 validen Quelltext erzeugen

- Der HTML Quelltext muss korrektes HTML5 Markup enthalten und W3C valide sein

Keyword Prominence (technisch)

- Das System muss im Quelltext den Content vor allen anderen Elementen der Seiten ausliefern (Nav, Footer etc). Mit anderen Worten, der HTML Quelltext muss via CSS so gestaltet sein, dass der Content vor der Navigation etc. steht.

- Das System muss die korrekte Semantik unterstützen

- Es sollte nur einen <H1> Tag pro Seite geben, dieser sollte den <title> und die Keywords der Seite enthalten. <H2-n>-Tags können beliebig oft verwendet wer-den. Der <title> Tag darf nicht generisch für alle Seiten gleich sein und der Titel darf nicht leer sein. Das System muss den Titel der Seite dynamisch erzeugen oder den Redakteur zur Eingabe zwingen.

Keyword Prominence (redaktionell)

- Das System muss dem Autor erlauben Texte und Keywords sauber zu platzieren

- Der Titel und die Überschriften sollten das Thema der Seite aufgreifen und so auf den Inhalt schließen lassen. Hierzu müssen die HTML Tags <title> <H1>, <H2>, <H3>, <b>, <li> verwendet werden. Jede Seite ist wird genau für einen Begriff optimiert.

- Das System muss ermöglichen, dass der Seitentitel vom Redakteur gepflegt werden kann.

- Der <title> Tag muss vom Redakteur gepflegt werden und maximal 60 Zeichen lang sein (Snippet-Länge in Google). (Vergleich Zeitungsseite)

Redaktionelle Kontrolle von MetaTag- Description

- Der MetaTag- -Description sollte vom Redakteur mit einer 100 bis 150 Zeichen langen menschenlesbaren Zusammenfassung der Seite befüllt werden (kein Keyword-stuffing).

- Der MetaTag-Keywords kann komplett entfallen.

Tags to Text Ratio

- Das System soll den HTML Quelltext ohne unnötiges Markup und unnötige Leer-zeichen und Umbrüche ausliefern. Der HTML Quelltext sollte keine unnötiges Markup enthalten sowie möglichst wenig unnötige Leerzeichen und Umbrüche enthalten (Tags to Text Ratio).

Das System muss DeepLink-fähig sein

- Jede URL sollte einzigartig und DeepLink-fähig sein.

Duplicate Content

- Das System muss Unique (atomare) URLs erzeugen und jeder Inhalt soll nur über eine URL erreichbar sein.

4.3 Referenzen für weitere Information zum Thema Suchmaschinen-Optimierung (SEO) und Werkzeuge

- Referenz für weiterführende Information zum Thema SEO

- Es existieren mehrere Quellen, um Wissen im Themenbereich Suchmaschinen-Optimierung zu erlangen bzw. aufzufrischen.

- In vielen Fällen liefern unterschiedliche Quellen stark auseinandergehende Informationen. Dies liegt vor allem an der Natur dieses Themengebietes, das sich mit unveröffentlichten „Geheimnissen“ der Suchmaschinen Provider beschäftigt.

- Sammlung von Links für mehr Information und zu Werkzeugen

- Analyse des Suchverhaltens getrennt nach Land und Sprache und daraus abgeleitet eine Liste mit bevorzugten Keywords/Keyphrases

- (Kostenlose) Werkzeuge (Tools), die helfen, relevante Keywords/Keyphrases zu analysieren und ihre Popularität zu erheben

- Analyse der Keyword Dichte, Häufigkeit und Prominenz ist während des redaktionellen Prozesses wichtig

- (Kostenlose) Werkzeuge, die helfen, die Dichte und Prominenz von Keywords und Keyphrases zu analysieren, z.B.

- etc. etc.

- (Kostenlose) Werkzeuge, die helfen, die Dichte und Prominenz von Keywords und Keyphrases zu analysieren, z.B.

- Eine Überprüfung einer Webseite darauf, wie Crawler diese Webseite sehen, ist wichtig um SEO zu verstehen

- (Kostenlose) Werkzeuge, die zu verstehen helfen wie Crawler eine Webseite sehen

- etc. etc.

- (Kostenlose) Werkzeuge, die zu verstehen helfen wie Crawler eine Webseite sehen

Hinterlasse einen Kommentar

An der Diskussion beteiligen?Hinterlasse uns deinen Kommentar!